在深度学习领域,往往需要处理复杂的任务场景,一般使用较深层数的模型进行网络设计,这就涉及到复杂困难的模型调参:学习率的设置,权重初始化的设置以及激活函数的设置等。深度学习之所以难以训练,一个重要的原因在神经网络中层与层之间存在着极强的关联性,并且目前绝大部分使用的都是基于梯度下降的方法进行反向传播训练,当网络的底层发生微弱变化时,这些变化会随着层数的增加被放大,意味着对于高层网络要不断进行参数更新以适应底层参数的变化,如此导致了训练的困难,很容易会出现梯度爆炸或者梯度消失的情况,导致模型训练失败。

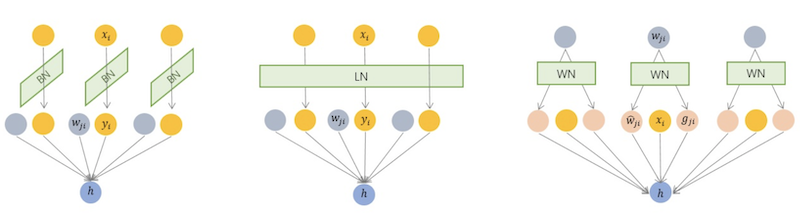

本文主要分析深度学习中的各种标准化方法(BN,LN,IN,GN,WN)的原理,来帮助实现对深度学习网络的训练。