论文地址:https://arxiv.org/pdf/2309.17453.pdf

代码地址:https://github.com/mit-han-lab/streaming-llm

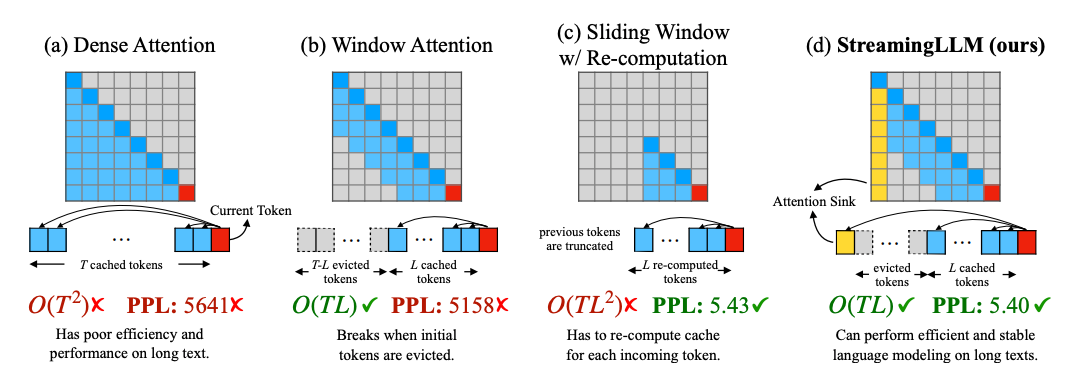

在LLM的训练和推理过程中,transformer的kv-cache一直是个非常头痛的问题,因为attention的计算机制,kv-cache是与输入的tokes数量呈平方关系的,在decoder结构中,第N步的forward都要计算前面的所有的N-1步的所有token,随着文本长度的增加,这会带来非常大的计算和存储开销。

在保证模型效果的条件小减少kv缓存是一个非常值得研究的事情。从下面徒可以看到,模型结合了window-attention和slide windiw的优势,有非常好的表现。